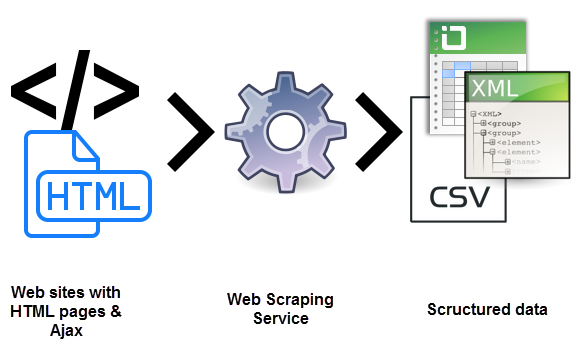

Vous êtes certainement demandé quel est le site Web de grattage. Il s’agit d’un processus d’utilisation des robots pour extraire du contenu et des données d’un site Web. De cette manière, le code HTML est extrait. Et, avec elle, les données stockées dans la base de données. Cela signifie que vous pouvez dupliquer ou copier tout le contenu du site Web ailleurs.

Le site Web de raclage est utilisé dans de nombreuses sociétés numériques qui sont dédiées à la collecte de bases de données. Pour clarifier mieux ce que le site Web de grattage doit savoir quels sont les cas d’utilisation légitime de celui-ci:

- Les robots des moteurs de recherche suivent un site, analysent leur contenu, puis le classent ensuite.

- Sites de comparaison de prix qui implémentent des robots pour obtenir automatiquement des prix et des descriptions de produits pour les sites Web des vendeurs alliés.

- Les sociétés de recherche sur le marché qui l’utilisent pour extraire des données de forums et de réseaux sociaux.

Pour avoir plus d’informations sur ce que le raclage Web doit savoir qu’elle est également utilisée à des fins illégales. Y compris le vol de raclage de prix et le vol de contenu de copyright. Une entité numérique affectée peut subir de graves pertes financières. Surtout s’il s’agit d’une entreprise fondée principalement sur des modèles de prix compétitifs ou des offres dans la distribution de contenu.

Savez-vous vraiment ce que le site Web de grattage est?

Les outils Web de raclage sont logiciels, c’est-à-dire des robots programmés pour examiner des bases de données et extraire des informations. Une grande variété de types de bouteilles est utilisée, beaucoup d’entre eux entièrement personnalisables pour:

- reconnaissent des structures de sites HTML uniques.

- extrait et transformer le contenu.

- Stockez des données.

- extraire des données de l’API.

Étant donné que tous les bots utilisent le même système pour accéder aux données du site, il est parfois difficile de distinguer entre des robots légitimes et des robots malveillants.

Différences clés entre bots légitimes et malveillants

Il existe des différences clés qui vous aideront à distinguer les deux:

- Les robots légitimes sont identifiés avec l’organisation pour laquelle ils le font. Par exemple, GoogleBot est identifié dans votre en-tête HTTP appartenant à Google. Les robots malveillants, en sens inverse, sont passés par le trafic légitime lors de la création d’un faux utilisateur HTTP.

- Les robots légitimes respectent le fichier robot.txt d’un site, qui répertorie les pages que vous pouvez accéder à un robot et ceux qui ne. Les méchants, d’autre part, suivent du site Web quel que soit l’opérateur de site autorisé.

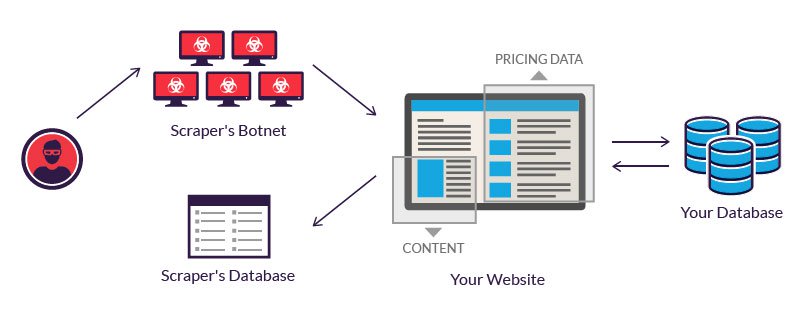

Les bots légitimes des bots investissent sur des serveurs pour traiter la grande quantité de données extraites. Un attaquant qui manque un tel budget, souvent recours à l’utilisation d’un réseau de bouteilles. C’est-à-dire des ordinateurs géographiquement dispersés, infectés par les mêmes logiciels malveillants et contrôlés à partir d’un emplacement central.

Les propriétaires d’ordinateurs de bots individuels ne sont pas au courant de leur participation. La puissance combinée des systèmes infectés permet de racler à grande échelle de nombreux sites Web différents de la part de l’auteur.

Exemples de ce que le site Web de grattage est

Le site Web de grattage est considéré comme malveillant lorsque les données sont extraites sans l’autorisation des propriétaires de sites Web. Les deux cas d’utilisation les plus courants sont des prix de grattage et du vol de contenu.

1.- Tarification de tarification

dans le prix du prix est l’une des variantes pour savoir quel est le site Web de grattage. C’est un attaquant qui utilise généralement un réseau BOT à partir duquel lancer Web raclant des robots pour inspecter les bases de données de la compétition. L’objectif est d’accéder à des informations sur les prix, de gagner des rivaux et de booster les ventes. Pour les attaquants, un raclage de prix réussi peut rendre vos offres soulignées sur les sites Web de comparaison.

Les attaques se produisent souvent dans les industries où le prix des produits est facilement comparable. Parce que le prix joue un rôle important dans les décisions d’achat. Les victimes de prix de raclage peuvent être des agences de voyages, des vendeurs en ligne électronique, etc.

Par exemple, des commerçants électroniques Smartphone, qui vendent des produits similaires à des prix relativement importants, sont des objectifs fréquents. Pour rester compétitif, ils doivent vendre leurs produits au meilleur prix possible.

Puisque les clients choisissent toujours de l’offre la plus économique.Pour obtenir un avantage, un fournisseur peut utiliser un bot pour gratter en permanence les sites Web de vos concurrents et mettre à jour presque instantanément vos propres tarifs en conséquence.

2.- Contenu de raclage

Craming Content est Une autre forme qui nous permet de comprendre ce que le site Web de grattage est. C’est-à-dire le vol à grande échelle d’un site particulier. Les objectifs typiques incluent des catalogues de produits en ligne et des sites Web basés sur le contenu numérique pour renforcer l’entreprise. Pour ces entreprises, une attaque de raclage de contenu peut être dévastatrice.

Par exemple, les répertoires d’entreprises en ligne investissent des quantités importantes, de l’argent et de l’énergie dans la construction de leur base de données. Le raclage peut tout faire aller à la frette. Il est utilisé dans les campagnes d’expédition de courrier indésirables. O Inverser aux concurrents. Il est probable que l’un de ces faits affectera les résultats d’une entreprise et ses opérations quotidiennes.

Protection contre la bande de raclage

1.- Il est important d’agir légalement

Le moyen le plus simple d’éviter de gratter est de prendre une mesure légale. Un dans lequel vous pouvez dire judicialement l’attaque et dans lequel vous montrez que la gratte Web n’est pas autorisée.

Vous pouvez même poursuivre des racleurs possibles si vous l’avez explicitement interdisciplément dans vos conditions d’utilisation. Par exemple, LinkedIn a poursuivi un ensemble de racleurs l’année dernière, affirmant que l’extraction des données utilisateur via des demandes automatisées équivalent à la piratage.

2.- Empêcher les attaques des demandes qui arrivent

Même si vous avez publié un avis juridique interdit de gratter vos services, il est possible qu’un attaquant potentiel souhaite toujours avancer avec le processus. Vous pouvez identifier les adresses IP possibles et empêcher les demandes d’atteindre votre service en filtrant via le pare-feu.

Bien qu’il s’agisse d’un processus manuel, les fournisseurs de services de cloud modernes vous donnent accès à des outils potentiels. Par exemple, si vous organisez vos services dans les services Web d’Amazon, le bouclier AWS aiderait à protéger votre serveur des attaques possibles.

3.- Utilisation des jetons de falsification (CSRF)

quand En utilisant des jetons CSRF dans votre application, vous éviterez des outils automatisés de faire des demandes arbitraires aux URL invitée. Un CSRF de jeton peut être présent sous forme de champ de forme cachée.

Pour surmonter un jeton CSRF, il est nécessaire de télécharger et d’analyser la marque et de rechercher le bon gonnez, avant de le regrouper avec la demande. Ce processus nécessite des compétences en programmation et un accès à des outils professionnels.

4.- Utilisez le fichier .htaccess pour éviter de gratter

.htacaccess est un fichier de configuration de votre serveur Web. Et peut être modifié pour empêcher les racleurs d’accéder à vos données. La première étape consiste à identifier des racleurs, ce qui peut être fait via Google Webmasters.

Une fois que vous les avez identifiées, vous pouvez utiliser de nombreuses techniques pour arrêter le processus de raclage en modifiant le fichier de configuration. En général, ce fichier n’est pas activé par ce que vous devez être activé, uniquement de cette façon, vous interpréterez les fichiers que vous allez placer dans votre répertoire.

5.- Empêcher le hotlinking

Lorsque vous avez rayé votre contenu, des liens en ligne vers des images et d’autres fichiers sont copiés directement sur le site de l’attaquant. Lorsque le même contenu est affiché sur le site de l’attaquant, ladite ressource est directement liée à votre site Web.

Ce processus de montrage d’une ressource hébergée sur le serveur sur un site Web différent s’appelle hotlinking. Lorsque vous évitez un lien actif, une image de ce type, lorsqu’elle est affichée sur un site différent, elle ne se fait pas via votre serveur.

– Adresses IP spécifiques spécifiques des listes noires

Si vous avez identifié les adresses IP ou les modèles d’adresse IP utilisés pour gratter, vous pouvez simplement les verrouiller à travers votre .htaccess.

7.- Limitez le nombre de demandes d’une adresse IP

comme alternative, vous pouvez également limiter le nombre de demandes d’une adresse IP. Bien que cela puisse ne pas être utile si un attaquant a accès à plusieurs adresses IP. Vous pouvez également utiliser un en cas de demandes anormales d’une adresse IP.

Ce que vous avez à faire est de bloquer l’accès des adresses IP connues du service de suivi de l’hébergement et du cloud pour vous assurer qu’un attaquant ne peut pas Utilisez ce service pour supprimer ou copier vos données.

8.- Créer « Honeypots »

A « Honeypot » est un lien vers un faux contenu invisible pour un utilisateur normal, mais Il est présent dans le HTML. Il apparaîtrait lorsqu’un programme analyse le site Web.En redirigeant un grattoir sur lesdits manuels, il peut détecter des racleurs et les faire perdre des ressources lors de la visite de pages qui ne contiennent pas de données.

Par conséquent, n’oubliez pas de désactiver ces liens dans votre fichier robots.txt à faire Assurez-vous qu’un fournisseur de moteurs de recherche ne finit pas dans ces chèvres.

9.- Modifier la structure du HTML fréquemment

la plupart des suiveurs analysent le HTML obtenu à partir du serveur. Pour rendre difficile l’accès à des racleurs à des données, vous pouvez fréquemment modifier la structure HTML. Pour ce faire, un attaquant doit à nouveau évaluer la structure de votre site Web pour extraire les données. Une autre clé de savoir quel est le site Web de grattage.

10.- Fournissez des API

Vous pouvez autoriser l’extraction de données sélective de votre site si vous définissez certaines règles. Une solution consiste à créer des API basées sur des abonnements pour surveiller et donner accès à vos données. À travers les API, vous pouvez également superviser et restreindre l’utilisation du service que vous proposez.

Si vous ne voulez pas avoir gratter des problèmes Web ou des complications de quelque nature que ce soit, vous devez toujours faire confiance aux plateformes qui vous donnent la sécurité. Et cela également, vous vous proposez les services dont vous avez besoin pour chaque campagne marketing. Et devant vous pouvez vous aider à cet égard. Faites confiance à nos services de marque & marketing de contenu et vous verrez comment il sera facile et efficace.